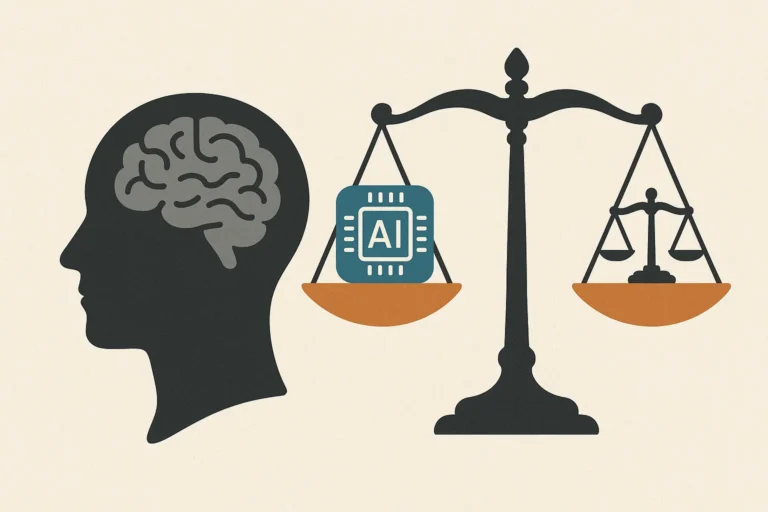

L’etica dell’AI rappresenta oggi uno dei temi più rilevanti nel dibattito sull’innovazione digitale. Con l’avanzare di tecnologie sempre più performanti, si rende necessario definire principi chiari che ne regolino l’utilizzo, garantendo trasparenza, equità e tutela dei diritti fondamentali. L’obiettivo non è rallentare il progresso, ma orientarlo in modo sostenibile e conforme ai valori umani.

Indice dei contenuti

Che cosa si intende per etica dell’AI

L’etica dell’intelligenza artificiale è l’insieme di principi e pratiche che mirano a massimizzare l’impatto positivo delle tecnologie AI, riducendo al minimo rischi e potenziali conseguenze negative. Questo ambito comprende aspetti come responsabilità, privacy, spiegabilità degli algoritmi, sostenibilità ambientale e prevenzione dell’uso improprio della tecnologia.

L’introduzione massiccia dei big data e l’automazione dei processi decisionali hanno accelerato l’adozione dell’AI nel settore privato. Tuttavia, progettazioni imprecise e dataset distorti hanno portato a risultati discriminatori e a problematiche etiche che oggi richiedono un intervento strutturato sia da parte delle aziende che del legislatore.

Principi fondamentali nell’ambito dell’etica dell’AI

Uno dei riferimenti più autorevoli per l’elaborazione di linee guida etiche è il Belmont Report, che individua tre principi fondamentali applicabili allo sviluppo di sistemi AI:

- Rispetto della persona, con particolare attenzione al consenso informato, soprattutto in presenza di utenti vulnerabili.

- Beneficenza, che richiama il principio “do no harm”, ovvero evitare che la tecnologia generi danni anche involontari, come la diffusione di bias.

- Giustizia, intesa come equità nella distribuzione di benefici e opportunità derivanti dall’uso dell’AI.

Foundation model e AI generativa: opportunità e criticità

L’arrivo di modelli generativi su larga scala, come ChatGPT, ha segnato un salto tecnologico significativo. Grazie alla loro capacità di adattarsi a molteplici applicazioni, tali sistemi aprono nuovi scenari in ambito medico, legale, industriale e comunicativo. Tuttavia, richiedono una valutazione etica rigorosa per contrastare fenomeni quali:

- alterazione della realtà tramite contenuti falsi,

- bias nei risultati,

- mancanza di trasparenza nel funzionamento degli algoritmi,

- uso improprio e rischio di manipolazione sociale.

Responsabilità e legislazione

Ad oggi non esiste una normativa universale applicata globalmente al settore AI. In Europa, tuttavia, è in via di definizione l’AI Act, che mira a introdurre criteri chiari sullo sviluppo e utilizzo dei sistemi ad alto rischio. In materia di protezione dei dati personali, resta centrale il Regolamento GDPR (UE 2016/679), che impone regole stringenti sull’utilizzo delle informazioni sensibili. Negli Stati Uniti, normative come il California Consumer Privacy Act (CCPA) costituiscono esempi di regolazione a livello statale.

L’applicazione responsabile dell’AI è oggi considerata essenziale per prevenire conseguenze legali, reputazionali e operative. La trasparenza e la tracciabilità dei sistemi diventano quindi requisiti imprescindibili.

AI e mercato del lavoro: trasformazione, non sostituzione

Il dibattito pubblico si concentra spesso sulla perdita di occupazione causata dall’AI. In realtà, come accaduto con altre rivoluzioni tecnologiche, si assiste più a una riconversione del mercato del lavoro che a una sostituzione massiva. L’AI può generare nuove professionalità, in particolare legate alla gestione dei dati, sicurezza informatica, supervisione tecnica e controllo etico delle tecnologie.

Bias e discriminazioni: quando l’AI amplifica gli errori umani

La presenza di pregiudizi nei dataset può portare gli algoritmi a generare decisioni discriminatorie. Noti casi aziendali hanno evidenziato come i processi di selezione automatizzata possano penalizzare alcuni gruppi sociali, spingendo realtà come IBM a prendere posizioni nette contro tecnologie applicate in modo scorretto, come il riconoscimento facciale utilizzato per finalità di sorveglianza o profilazione.

Modelli di governance e qualità dell’AI

Per garantire l’affidabilità dei sistemi, molte aziende hanno introdotto organismi interni come AI Ethics Board, incaricati di supervisionare l’attuazione di protocolli responsabili. Tra le aree strategiche su cui orientare la governance troviamo:

- spiegabilità, per rendere comprensibile il funzionamento dei sistemi,

- solidità, per proteggere la tecnologia da attacchi e manipolazioni,

- trasparenza, per favorire la fiducia degli stakeholder,

- equità, per assicurare che l’AI contribuisca alla riduzione delle disuguaglianze,

- privacy, per tutelare i diritti dei cittadini nell’utilizzo dei dati.

Il modello adottato da IBM

IBM ha definito un framework etico basato su tre principi cardine:

- supporto all’intelligenza umana,

- tutela della proprietà dei dati,

- trasparenza dei sistemi AI.

L’approccio è rafforzato da cinque pilastri operativi: spiegabilità, equità, solidità, trasparenza e protezione dei dati personali. Una strategia orientata a garantire innovazione responsabile e fiducia nelle tecnologie emergenti.